唯一索引

查询

对于普通索引来说,查找到满足条件的第一个记录后,需要查找下一个记录,直到碰到第一个不满足条件的记录。

对于唯一索引来说,由于索引定义了唯一性,查找到第一个满足条件的记录后,就会停止继续检索。

这个不同带来的性能差距会有多少呢?答案是,微乎其微。InnoDB 的数据是按数据页为单位来读写的。也就是说,当需要读一条记录的时候,并不是将这个记录本身从磁盘读出来,而是以页为单位,将其整体读入内存。在 InnoDB 中,每个数据页的大小默认是 16KB。

因为引擎是按页读写的,所以说,当找到满足条件的记录的时候,它所在的数据页就都在内存里了。那么,对于普通索引来说,要多做的那一次“查找和判断下一条记录”的操作,就只需要一次指针寻找和一次计算。(如果这条记录正好是该页的最后一条记录,就需要读取下一个数据页)

更新

为了说明普通索引和唯一索引对更新语句性能的影响这个问题,首先介绍一下 change buffer。

当需要更新一个数据页时,如果数据页在内存中就直接更新。而如果这个数据页还没有在内存中的话,在不影响数据一致性的前提下,InnoDB 会将这些更新操作缓存在 change buffer 中,这样就不需要从磁盘中读入这个数据页了。在下次查询需要访问这个数据页的时候,将数据页读入内存,然后执行 change buffer 中与这个页有关的操作。通过这种方式就能保证这个数据逻辑的正确性。

需要说明的是,虽然名字叫作 change buffer,实际上它是可以持久化的数据。也就是说,change buffer 在内存中有拷贝,也会被写入到磁盘上。

将 change buffer 中的操作应用到原数据页,得到最新结果的过程称为 merge。

访问这个数据页会触发 merge 外,系统有后台线程会定期 merge。在数据库正常关闭的过程中,也会执行 merge 操作。

显然,如果能够将更新操作先记录在 change buffer,减少读磁盘,语句的执行速度会得到明显的提升。而且,数据读入内存是需要占用 buffer pool 的,所以这种方式还能够避免占用内存,提高内存利用率。

什么条件下可以使用 change buffer 呢?

对于唯一索引来说,所有的更新操作都要先判断这个操作是否违反唯一性约束,而且要将数据页读入内存才能判断。如果都已经读入到内存了,那直接更新内存会更快,就没必要使用 change buffer 了。因此,唯一索引的更新就不能使用 change buffer,实际上也只有普通索引可以使用。

change buffer 用的是 buffer pool 里的内存,因此不能无限增大。change buffer 的大小,可以通过参数 innodb_change_buffer_max_size 来动态设置。

InnoDB 的处理流程

如果记录要更新的目标页在内存中

- 对于唯一索引来说,找到 对应的位置,判断到没有冲突,插入这个值,语句执行结束;

- 对于普通索引来说,找到 对应的位置,插入这个值,语句执行结束。

如果记录要更新的目标页不在内存中

- 对于唯一索引来说,需要将数据页读入内存,判断到没有冲突,插入这个值,语句执行结束;

- 对于普通索引来说,则是将更新记录在 change buffer,语句执行就结束了。

将数据从磁盘读入内存涉及随机 IO 的访问,是数据库里面成本最高的操作之一。change buffer 因为减少了随机磁盘访问,所以对更新性能的提升是会很明显的。

change buffer 适合写多读少的场景。因为 merge 的时候是真正进行数据更新的时刻,而 change buffer 的主要目的就是将记录的变更动作缓存下来,所以在一个数据页做 merge 之前,change buffer 记录的变更越多(也就是这个页面上要更新的次数越多),收益就越大。对于写入之后马上会做查询的场景,随机访问 IO 的次数不会减少,反而增加了 change buffer 的维护代价。

change buffer 和 redo log

1 | insert into t(id,k) values(id1,k1),(id2,k2); |

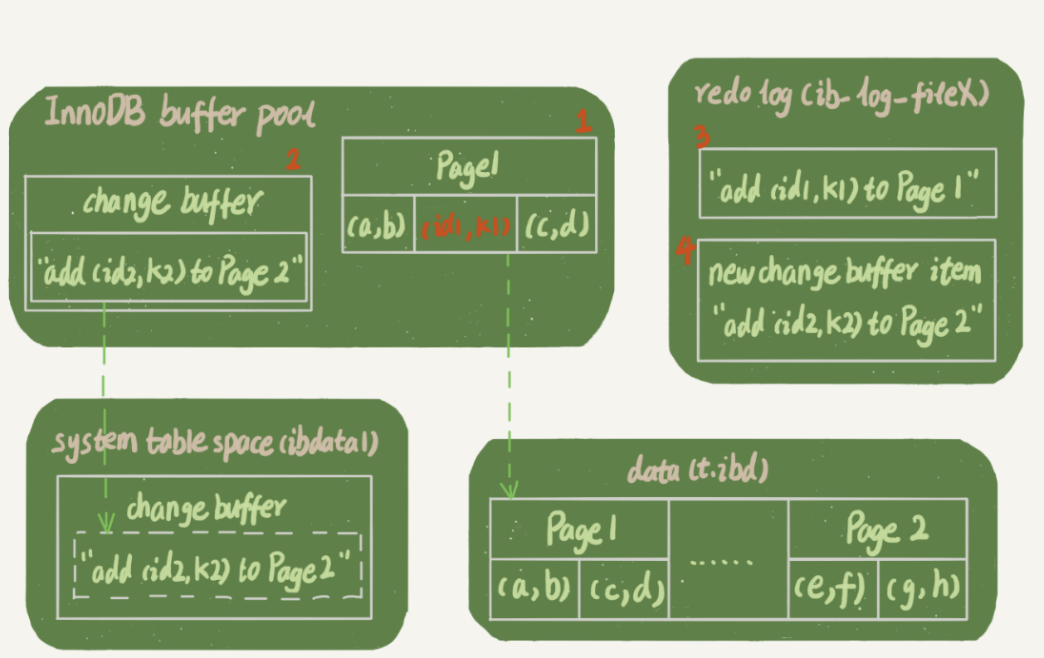

假设当前 k 索引树的状态,查找到位置后,k1 所在的数据页在内存 (InnoDB buffer pool) 中,k2 所在的数据页不在内存中。下图所示是带 change buffer 的更新状态图。

分析这条更新语句,涉及了四个部分:内存、redo log(ib_log_fileX)、 数据表空间(t.ibd)、系统表空间(ibdata1)。

Page 1 在内存中,直接更新内存;

Page 2 没有在内存中,就在内存的 change buffer 区域,记录下“我要往 Page 2 插入一行”这个信息

将上述两个动作记入 redo log 中(图中 3 和 4)

之后的读请求

1 | select * from t where k in (k1, k2) |

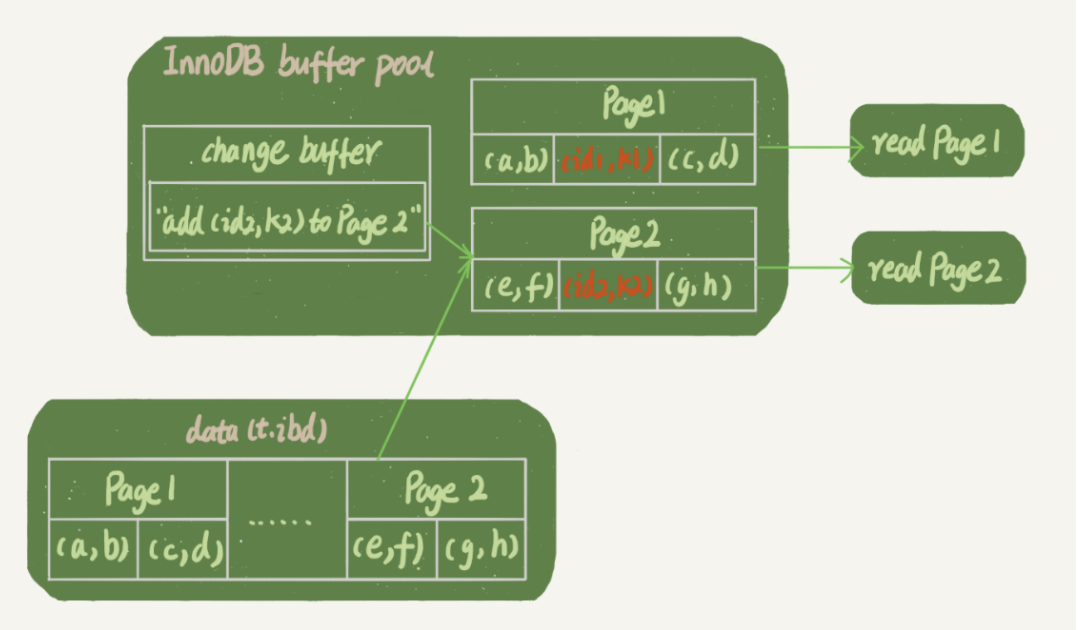

如果读语句发生在更新语句后不久,内存中的数据都还在,那么此时的这两个读操作就与系统表空间(ibdata1)和 redo log(ib_log_fileX)无关了。

- 读 Page 1 的时候,直接从内存返回。

- 要读 Page 2 的时候,需要把 Page 2 从磁盘读入内存中,然后应用 change buffer 里面的操作日志,生成一个正确的版本并返回结果。

redo log 主要节省的是随机写磁盘的 IO 消耗(转成顺序写),而 change buffer 主要节省的则是随机读磁盘的 IO 消耗。

字符串字段加索引

假设,现在维护一个支持邮箱登录的系统,用户表是这么定义的:

1 | mysql> create table SUser(ID bigint unsigned primary key,email varchar(64), ... )engine=innodb; |

由于要使用邮箱登录,所以业务代码中一定会出现类似于这样的语句:

1 | mysql> select f1, f2 from SUser where email='xxx'; |

如果 email 这个字段上没有索引,那么这个语句就只能做全表扫描。

MySQL 是支持前缀索引的,也就是说,你可以定义字符串的一部分作为索引。默认地,如果你创建索引的语句不指定前缀长度,那么索引就会包含整个字符串。

1 | -- 第一个语句创建的 index1 索引里面,包含了每个记录的整个字符串; |

由于 email(6) 这个索引结构中每个邮箱字段都只取前 6 个字节,所以占用的空间会更小,这就是使用前缀索引的优势。但,这同时带来的损失是,可能会增加额外的记录扫描次数。

看看下面这个语句,在这两个索引定义下分别是怎么执行的。

1 | select id,name,email from SUser where email='zhangssxyz@xxx.com'; |

如果使用的是 index1

- 从 index1 索引树找到满足索引值是’zhangssxyz@xxx.com’的这条记录,取得 ID2 的值;

- 到主键上查到主键值是 ID2 的行,判断 email 的值是正确的,将这行记录加入结果集;

- 取 index1 索引树上刚刚查到的位置的下一条记录,发现已经不满足 email=‘zhangssxyz@xxx.com’的条件了,循环结束。

如果使用的是 index2

- 从 index2 索引树找到满足索引值是’zhangs’的记录,找到的第一个是 ID1;

- 到主键上查到主键值是 ID1 的行,判断出 email 的值不是’zhangssxyz@xxx.com’,这行记录丢弃;

- 取 index2 上刚刚查到的位置的下一条记录,发现仍然是’zhangs’,取出 ID2,再到 ID 索引上取整行然后判断,这次值对了,将这行记录加入结果集;

- 重复上一步,直到在 idxe2 上取到的值不是’zhangs’时,循环结束。

使用前缀索引,定义好长度,就可以做到既节省空间,又不用额外增加太多的查询成本。

在建立索引时关注的是区分度,区分度越高越好。因为区分度越高,意味着重复的键值越少。

前缀索引的影响不止如此,我们再看一下另外一个场景。

1 | select id,email from SUser where email='zhangssxyz@xxx.com'; |

如果使用 index1,可以利用覆盖索引,从 index1 查到结果后直接就返回了,不需要回到 ID 索引再去查一次。

如果使用 index2,就不得不回到 ID 索引再去判断 email 字段的值。

即使你将 index2 的定义修改为 email(18) 的前缀索引,这时候虽然 index2 已经包含了所有的信息,但 InnoDB 还是要回到 id 索引再查一下,因为系统并不确定前缀索引的定义是否截断了完整信息。使用前缀索引就用不上覆盖索引对查询性能的优化